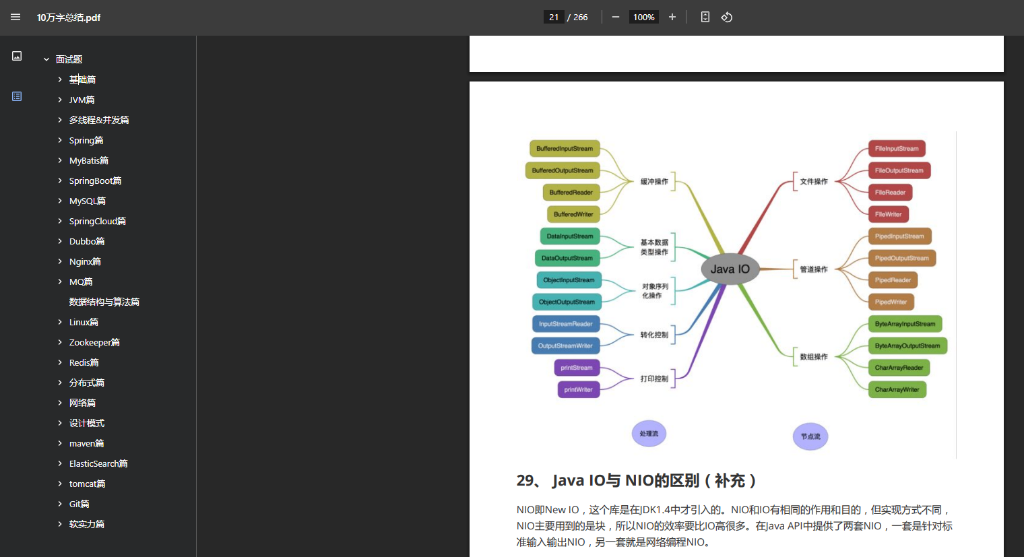

kafka的重复消费、如何解决

2025年Java面试宝典重磅发布!百度网盘链接免费下载,包含最新Kafka高频面试题解析,如重复消费问题解决方案、幂等性设计、Offset提交策略等核心知识点。这份资料由大厂架构师整理,涵盖Java核心技术栈和分布式系统设计,助你备战金三银四求职季。特别推荐结合Redis实现消息去重、Kafka事务机制等实战技巧,附赠真实业务场景案例和性能优化方案。立即点击链接获取:https://pan.baidu.com/s/1RUVf75gmDVsg8MQp4yRChg 提取码9b3g,提升面试通过率!

2025年Java面试宝典

链接: https://pan.baidu.com/s/1RUVf75gmDVsg8MQp4yRChg?pwd=9b3g 提取码: 9b3g

Kafka的重复消费、如何解决

作为消息中间件的核心组件,Kafka的高吞吐和分布式特性让它成为互联网公司的标配。但面试中经常被问到一个问题:“Kafka为什么会重复消费?如何解决?” 下面我会结合真实业务场景,帮你梳理清楚这个问题的本质和解决方案。

为什么会出现重复消费?

重复消费的根本原因在于消费者提交偏移量(Offset)的时机和消息处理的可靠性不匹配。常见的触发场景有:

- 消费者提交Offset失败:如果消费者在处理完消息后崩溃,未成功提交Offset,重启后会重新消费已处理过的数据。

- 消费者重平衡(Rebalance):当消费者组内成员增减(如扩容或宕机),Kafka会重新分配分区。此时如果消费者未及时提交Offset,可能导致部分消息被重复处理。

- 手动提交Offset的误操作:如果使用手动提交模式,但代码中先处理消息再提交Offset,若处理完成后提交失败,也会导致重复消费。

解决问题的4个核心思路

1. 保证消息处理的幂等性

幂等性是解决重复消费的最直接手段。例如,订单系统可以通过**唯一业务标识(如订单ID)**判断消息是否已处理。伪代码逻辑:

if (订单ID不存在) {

处理消息;

记录订单ID到数据库;

}

2. 启用Kafka的事务消息

对于金融等高敏感场景,可结合Kafka事务机制:

- 生产者:发送消息时开启事务,确保消息原子性写入。

- 消费者:处理消息和提交Offset放在同一个事务中,保证两者同时成功或失败。

3. 借助外部存储去重

将已处理消息的Offset或唯一标识存储在Redis、MySQL等外部系统。例如:

- 使用Redis的Set结构存储已消费的订单ID,每次消费前先查询。

- 注意设置合理的过期时间,避免存储膨胀。

4. 合理配置手动提交策略

如果使用手动提交Offset:

- 同步提交:

consumer.commitSync()确保提交成功后才继续消费。 - 异步提交+重试:用

consumer.commitAsync()提高性能,但需要配合重试机制。

生产环境最佳实践

- 优先选择幂等性设计:业务层去重成本最低,且不受Kafka版本限制。

- 控制消费者提交Offset的频率:在消息处理完成后立即提交,避免堆积导致重平衡时大量重复。

- 监控消费者组的延迟:通过

kafka-consumer-groups.sh工具观察Lag值,及时发现异常。 - 设置合理的重试策略:例如退避重试(Exponential Backoff),避免因短暂故障反复重试。

总结

重复消费的本质是系统设计中的“至少一次”语义带来的副作用,解决思路围绕幂等性和可靠性提交展开。在面试中回答这个问题时,可以先从原因切入,再分层给出解决方案(如业务层、存储层、Kafka机制)。如果遇到压力追问(比如“如何在高并发下实现高效去重”),可以提到分片Redis或布隆过滤器的优化思路。

如果需要购买面试鸭会员,可以通过面试鸭返利网找到我,返利25元哦! 另外,前面提到的Java面试宝典网盘资料包含了Kafka的高频考点,建议提前复习~

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!