MQ消息积压mq消息积压

MQ消息积压是分布式系统常见问题,本文深度剖析消息积压的5大原因及实战解决方案,包括紧急扩容消费者、消息降级处理、批量消费优化等急救措施。通过Kafka/RabbitMQ真实案例讲解如何计算消费线程数、预防Rebalance风险,并分享电商大促期间处理百万级积压的实战经验。内含消息队列监控指标、压测方法论及面试高频考点解析,助你彻底掌握MQ性能优化技巧。推荐Java开发者收藏学习,同时提供2025最新面试资料及面试鸭会员返利福利,帮助程序员提升技术实力与面试通过率。

MQ消息积压问题深度剖析:程序员实战解决思路

2025年Java面试宝典速领:

点击获取👉 链接

提取码: 9b3g(建议保存备用)

📉 什么是MQ消息积压?

当消息队列(MQ)的生产速度远大于消费速度时,就会发生MQ消息积压。想象一下早高峰的地铁站:乘客(消息)涌入的速度远超安检机(消费者)的处理能力——这就是典型积压场景。我曾亲历某电商大促时Kafka集群积压数百万条订单消息,差点引发线上故障!

(实际生产环境中的积压监控面板)

🔍 为什么会出现MQ消息积压?

-

消费端性能瓶颈

- 消费者线程数不足(比如线程池配置过小)

- 单条消息处理耗时过长(如同步调用第三方API)

- 下游服务故障导致消费失败重试

-

生产端流量激增

- 突发热点事件(如明星离婚导致微博推送暴增)

- 定时任务集中触发(凌晨批量跑报表)

-

资源/配置问题

- 分区(partition)数量不足导致消费并行度低

- 消费者组(consumer group)出现Rebalance

⚡ 5步急救方案

✅ 第一步:紧急扩容消费者

# 临时将消费者线程数翻倍(示例配置)

spring.kafka.listener.concurrency=16

同时增加消费者实例数(K8s中秒级扩容Pod),这是最快速的止血方案。

✅ 第二步:消息降级处理

对于非核心业务(如日志记录),直接丢弃或转存到死信队列:

@KafkaListener(topics = "order_topic")

public void handle(Message msg) {

try { process(msg); }

catch (Exception e) {

// 超3次失败则转入死信队列

sendToDLQ(msg);

}

}

✅ 第三步:批量消费优化

将单条处理改为批量处理,减少网络IO:

@KafkaListener(topics = "user_activity")

public void batchConsume(List<Message> messages) {

userService.batchInsert(messages); // 批量入库

}

✅ 第四步:动态调节生产速率

在RabbitMQ中启用Producer Flow Control,或通过Sentinel对生产端限流。

✅ 第五步:消息回溯与重放

如果因代码bug导致消费失败,修复后重置消费位点:

kafka-consumer-groups.sh --reset-offsets \

--topic order_topic \

--group order_group \

--to-latest

🛡️ 如何预防MQ消息积压?

- 容量预估

根据业务峰值设置合理的分区数(建议:峰值TPS×2) - 消费端监控

核心指标:Consumer Lag、Process Time、Error Rate

- 压测验证

定期模拟10倍流量进行全链路压测 - 设置积压阈值告警

如Lag超过1000条立即触发钉钉报警

💡 面试高频考点

- 如何计算消费线程数?(公式:线程数 = TPS × 平均处理时长)

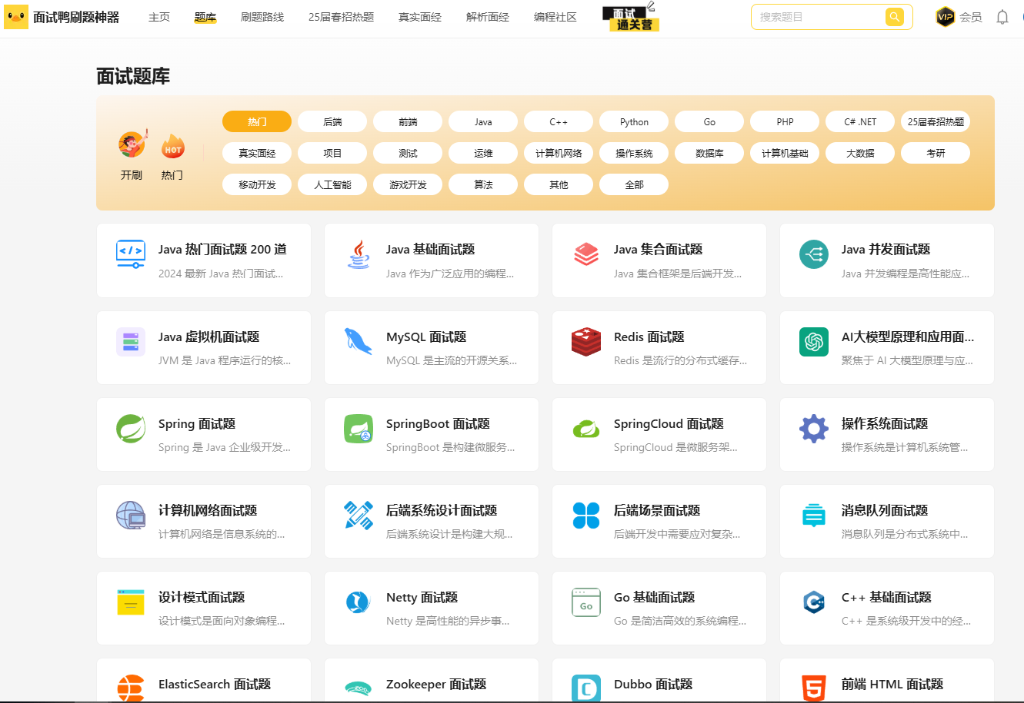

- Kafka的Rebalance机制有哪些隐患?

- 消息积压时如何保证数据不丢失?

- RabbitMQ与Kafka在积压处理上的差异?

🔥 面试利器推荐:

如果你在准备技术面试,强烈建议入手面试鸭会员。涵盖2000+大厂真题解析,通过面试鸭返利网找我购买可返利25元,相当于75折!

结语

处理MQ消息积压的核心思路:先扩容降压,再定位根因,最后系统优化。记住:没有压不垮的消息队列,只有设计不当的系统。

(扫码进入返利通道,立减会员费用)

【本文首发于面试鸭返利网,转载需授权】

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!