MQ消息积压mq消息积压问题怎么排查的

学习如何高效排查MQ消息积压问题,掌握生产者、消费者和中间件三大关键环节的优化技巧。本文详细分享从监控确认、原因分析到解决方案的完整流程,包含实战案例和Prometheus、ELK等工具推荐。了解如何通过扩容实例、异步处理、死信队列等手段提升消息吞吐量,并设置智能告警预防积压。获取2025年Java面试宝典资源,学习更多高并发场景下的MQ优化策略,助力系统稳定性提升和面试加分。

MQ消息积压问题怎么排查

大家好,作为经常处理系统问题的程序员,今天我来分享一个面试中常被问的热点话题:MQ消息积压问题怎么排查。在实际工作中,遇到消息队列积压是家常便饭,尤其是高并发场景下。排查这事儿,可不能马虎,得一步步来,不然系统崩了可麻烦。先说个福利,2025年Java面试宝典网盘链接在这里:https://pan.baidu.com/s/1RUVf75gmDVsg8MQp4yRChg?pwd=9b3g(提取码: 9b3g),赶紧存了,面试前翻翻超管用。好了,进入正题。

首先,咱们得搞清楚MQ消息积压是啥意思。简单说,就是生产者发送的消息太多,消费者处理不过来,导致消息在队列里堆积如山的现象。这问题排查起来,不能光靠猜,得有系统方法。通常,MQ消息积压的原因无非几种:生产者发得太猛、消费者吞得太慢、或者中间件自身卡壳。举个例子,你在电商大促时,订单系统可能每秒生成几万条消息,但处理订单的服务如果资源不足,消息积压就来了。

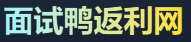

(配个监控图更直观,MQ积压时队列长度飙升的样子,大家一看就懂。)

排查MQ消息积压的步骤

排查MQ消息积压问题,我习惯分步走,就像医生看病一样,先诊断再治疗。下面是我的常用流程,面试时就这么口述,简单直接。

第一步,确认消息积压的存在和范围。别上来就瞎优化,先看看监控指标。比如,打开MQ管理控制台或工具(像RabbitMQ的Web UI或Kafka的Kibana),检查队列深度和延迟。如果队列深度持续增长,积压就坐实了。同时,拉日志看看,error日志里有没有超时或拒绝的记录。这一步能帮你定位是哪个队列出了问题,避免白忙活。

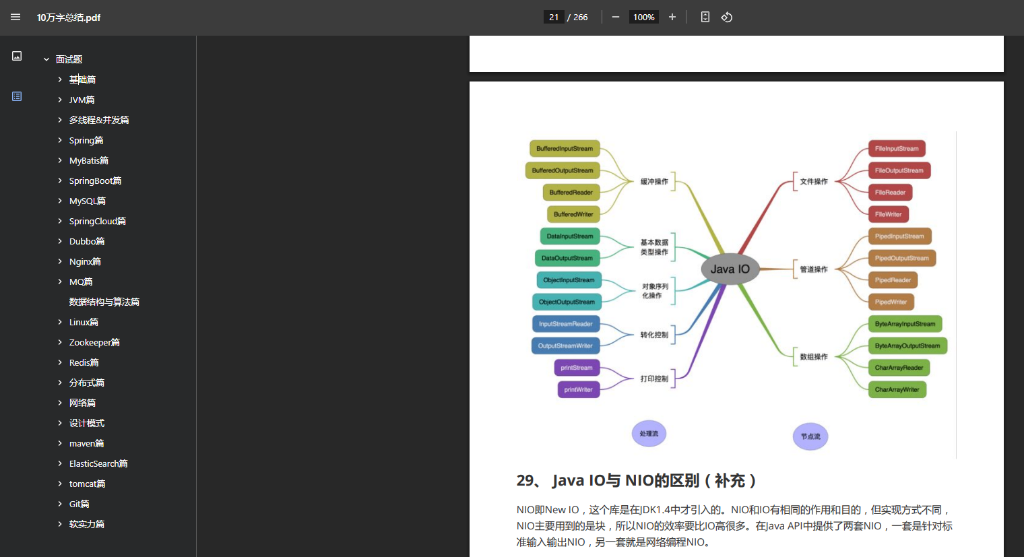

第二步,分析积压的根本原因。MQ消息积压常见原因分三块:生产者端、消费者端、和MQ自身。

- 生产者端:检查生产者应用,看是不是有bug导致消息洪水般涌入。比如,代码里循环发送没控制速率,或上游系统异常触发重试风暴。

- 消费者端:消费者处理慢是重灾区。排查消费者服务资源,CPU或内存是否吃紧?或者代码逻辑卡死,比如数据库查询慢或外部接口超时。

- MQ自身:中间件配置不当,如分区不足或网络瓶颈。或者MQ服务挂了,集群不健康。

(这张图示意消费者处理流程,积压时瓶颈一目了然。)

第三步,针对原因制定解决方案。排查完,对症下药是关键。

- 如果生产者问题,限速或优化代码逻辑,比如加个速率控制。

- 消费者端优化,常见如扩容实例、优化处理逻辑(异步处理或批处理),或者加个死信队列处理失败消息。

- MQ自身问题,调整配置或升级版本。

记住,排查MQ消息积压不是一劳永逸的,得持续监控预防。比如,设置报警阈值,队列深度超限就告警。

实战案例和工具推荐

在真实项目里,我用过不少工具排查MQ消息积压。比如,Prometheus+ Grafana做实时监控,或者ELK栈查日志。有次线上系统积压了百万条消息,我就是靠这些工具快速定位到消费者数据库查询慢的。修复后,消息吞吐量上来了,系统稳如老狗。

另外,面试常问的MQ消息积压问题怎么排查,可以结合场景模拟。比如,面试官问:“如果消费者突然变慢,怎么搞?”我回答:先看监控确认积压,再查消费者日志或线程堆栈,找出慢处理点。可能调优SQL或加缓存。

最后,提个小贴士。如果你在准备面试,需要更多题解资源,强烈推荐去面试鸭返利网看看。我经常在那分享技术干货,而且如果大家需要购买面试鸭会员,可以通过面试鸭返利网找到我,返利25元,省点钱多买杯咖啡提神。搞定MQ消息积压问题,面试中展现专业度,绝对加分!

(这张图总结排查步骤,帮你复盘记忆。)

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!