MQ消息积压怎么解决mq的消息积压

MQ消息积压怎么解决?50万条消息积压紧急处理方案来了!本文分享RabbitMQ/Kafka消息堆积5步实战:立即定位积压队列、快速扩容消费者集群、优化消费逻辑批处理、生产端限流降级、百万级数据迁移处理。包含监控预警设置、并发参数调整、死信队列排查等核心技术,附Kafka重置offset命令和Spring并发配置示例。预防MQ消息积压必看:容量规划、压测演练、灰度发布全攻略,助你成为分布式系统问题解决专家!

MQ消息积压怎么解决mq的消息积压

立即获取面试资料:2025年Java面试宝典下载地址:

https://pan.baidu.com/s/1RUVf75gmDVsg8MQp4yRChg?pwd=9b3g

(涵盖高并发、分布式、MQ等高频考点)

先讲个真实场景:凌晨3点被告警吵醒,监控大屏飘红——RabbitMQ某个队列积压了50万条消息。这种mq的消息积压如果不快速解决,轻则业务延迟,重则雪崩宕机。作为踩过坑的老司机,分享几个实战处理方案:

第一步:立即止血,定位积压源头

消息积压往往是消费能力不足导致的。先用rabbitmqctl list_queues或Kafka的kafka-consumer-groups.sh查看:

- 哪个Topic/Queue在积压

- 消费者数量是否足够

- 消息生产速率是否异常暴涨

通过监控快速定位积压队列

第二步:临时扩容消费者集群

这是解决MQ消息积压最快的方式:

- 新增Consumer实例:直接加机器或开容器

- 调整并发参数:比如Spring的

concurrency从10调到50 - 注意:DB连接池等配套资源需同步扩容

# Kafka紧急扩容示例

bin/kafka-consumer-groups.sh --bootstrap-server localhost:9092 \

--group my-group --reset-offsets --to-latest --execute

第三步:消费逻辑优化

扩容治标,优化治本:

- 批处理消费:单条处理改批量(如ES写入)

- 异步非阻塞:避免同步调用第三方服务

- 跳过非核心逻辑:紧急时先存Redis延后处理

- 死信队列监控:避免因消息格式错误导致阻塞

优化消费链路是根治消息积压的关键

第四步:生产端限流降级

当积压量超过10万时,必须干预生产端:

- 消息队列侧:启用

x-max-length设置队列上限 - 网关层:对非关键业务请求限流

- 降级策略:直接抛弃低优先级消息

第五步:积压数据迁移处理

百万级积压需特殊手段:

# Kafka重置offset回溯消费

bin/kafka-consumer-groups.sh --group my_group \

--topic orders --reset-offsets --to-datetime 2024-07-01T00:00:00Z

- 单独启ETL程序消费历史数据

- 导出到HDFS/对象存储做离线补偿

预防才是终极方案

避免下次再为mq的消息积压熬夜:

- 监控预警:设置堆积阈值自动告警

- 压测演练:定期模拟流量峰值

- 灰度机制:新消费者逐步上线验证

- 容量规划:根据业务增长预留30%缓冲

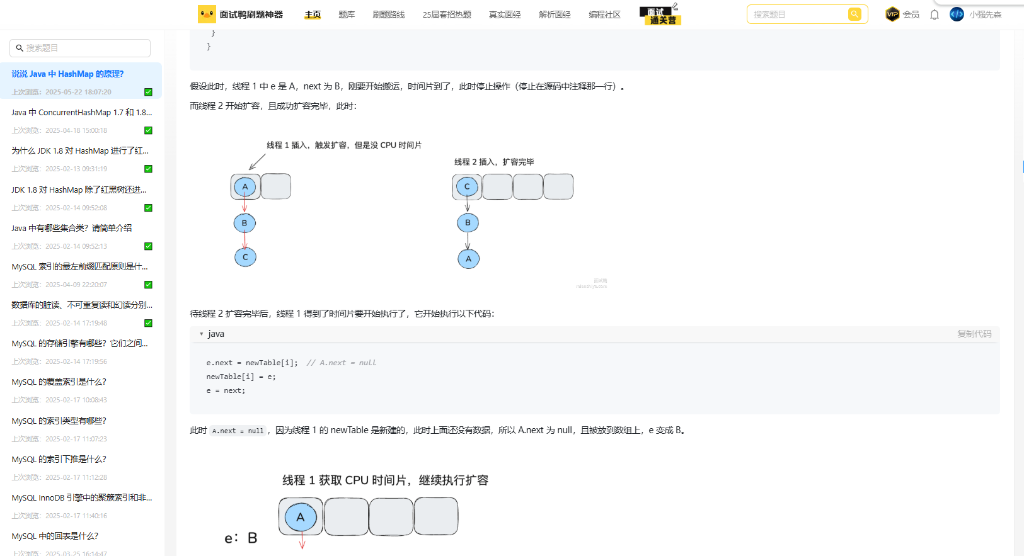

最后安利个福利:最近在面试鸭返利网开通了返利通道,通过本站购买面试鸭会员可返现25元(官方原价无折扣),需要刷题备战的朋友可以戳:

点击图片进入活动页

记住核心口诀:监控早发现,扩容快止血,优化除病根。搞定消息积压,你就是下一个OnCall战神!

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!