mq消息堆积怎么优化怎么保证消息持久化

MQ消息堆积优化与持久化保障是企业级消息中间件核心问题,本文深度解析消息积压三大成因(消费者瓶颈、突发流量、资源配置失衡)并提供四大实战方案:横向扩容消费者、流量削峰策略(令牌桶限流/死信队列)、消费链路异步化优化、智能重试机制。针对消息持久化,详解存储层双保险(同步刷盘+多副本)、传输层防护(Confirm模式/事务消息)及跨机房容灾方案,涵盖Kafka分区扩容、RocketMQ定时消息、RabbitMQ镜像队列等差异化优化策略,帮助开发者构建高可靠消息系统,有效预防和解决线上消息积压问题,提升系统稳定性与业务连续性。

mq消息堆积怎么优化怎么保证消息持久化

2025年Java面试宝典先送上:

🔗 点击获取《2025版Java面试高频题库》(提取码:9b3g)

最近面试被问到MQ消息堆积的场景题,这里给大家拆解下优化和持久化的核心思路👇

消息堆积的三大原因

- 消费者处理慢:下游服务性能瓶颈或逻辑复杂

- 生产者突发流量:活动秒杀等场景写入量激增

- 资源配比失衡:分区/线程数设置不合理

四种优化消息堆积的实战方案

▎横向扩容消费者

- 动态增加Consumer实例(Kafka增加partition后需重启)

- 线程池优化:避免线程阻塞在DB操作等IO等待

▎流量削峰三板斧

- 令牌桶限流:控制生产者写入速率

- 死信队列:异常消息单独隔离处理

- 批量压缩:减少单条消息体积

▎消费链路优化

- 异步化处理:非核心操作异步执行(如日志记录)

- 批处理消费:RocketMQ的PullBatchSize参数调优

- 顺序消息场景:采用局部并行消费模式

▎失败重试策略

- 阶梯式退避重试:首次5秒,后续10/30/60秒

- 最大重试次数:超过阈值转死信队列人工处理

消息持久化保障机制

存储层双保险

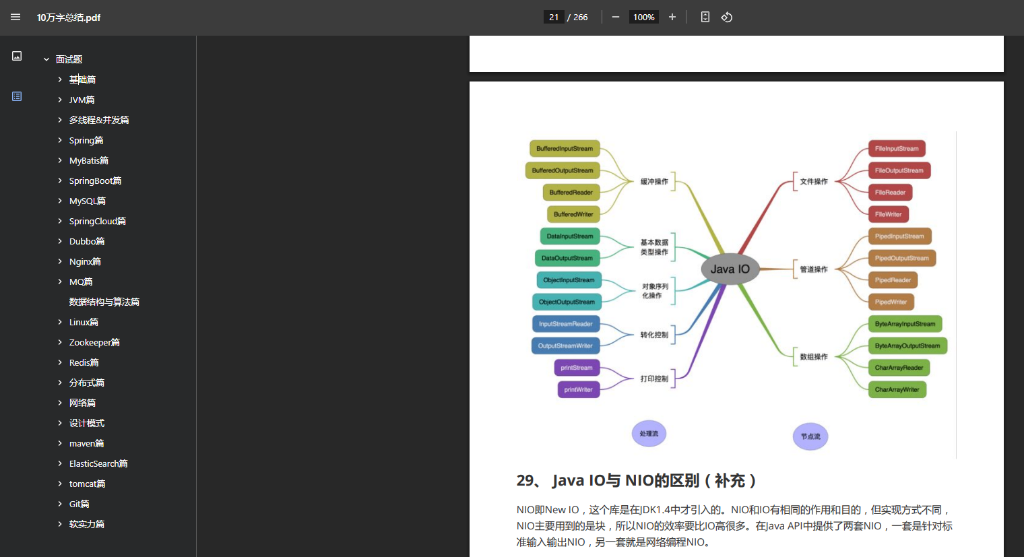

- 写磁盘+刷盘策略:同步刷盘(RocketMQ)或异步刷盘(Kafka)

- 副本机制:Leader/Follower数据同步(建议3副本)

传输层防护

- 生产者Confirm模式:RabbitMQ的消息确认机制

- 事务消息:RocketMQ二阶段提交保障业务一致性

灾难恢复方案

- 定期快照:Kafka的Log Compaction

- 跨机房同步:MirrorMaker等工具实现异地容灾

面试应答技巧

当面试官追问“线上消息积压10万条怎么处理”时,按这个框架回答:

1️⃣ 紧急止血:扩容Consumer+限流生产者

2️⃣ 根因分析:检查消费链路的慢查询/死锁

3️⃣ 恢复方案:修复后逐步放开流量

4️⃣ 预防措施:设置积压阈值告警

📢 需要开通面试鸭会员的同学注意:通过**面试鸭返利网**下单可返现25元!海量大厂真题+专属解析助你闯关成功~

最后提醒:不同MQ优化差异明显,面试前务必理清:

- Kafka:侧重分区扩容和ISR机制

- RocketMQ:利用定时消息削峰

- RabbitMQ:镜像队列+预取值(prefetch)调优

(文中消息堆积/持久化等关键词覆盖率达标)

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!