mq中的消息持久化

面试必问的MQ消息持久化机制深度解析:从Kafka顺序写盘到RabbitMQ异步刷盘,全面剖析消息队列如何保障数据不丢失。本文详解同步/异步刷盘策略差异、磁盘存储优化技巧(零拷贝、分段日志)、高可用设计(ISR副本机制),并提供电商/金融等场景下的持久化选型建议。附2025最新Java面试题库及MQ专项训练资料下载,助你攻克分布式系统可靠性难题。通过面试鸭返利网开通会员还可享25元返现优惠,立即获取大厂面试通关秘籍!

MQ中的消息持久化:面试必问的核心机制解析

2025年Java面试宝典抢先领:

🔗 百度网盘链接

提取码:9b3g

一、为什么面试官总揪着消息持久化不放?

每次面试被问到MQ(Message Queue)时,「消息持久化」几乎是必考题。我当年在阿里三面就被连环追问:

"如果服务器突然断电,如何保证订单消息不丢失?"

"Kafka和RabbitMQ的持久化实现有什么区别?"

这背后考察的是你对分布式系统可靠性的底层认知。消息持久化不仅是MQ的核心能力,更是系统高可用的生死线。

二、消息持久化到底在解决什么问题?

想象这个场景:用户支付成功的消息进入MQ后,消费者还没处理完,MQ服务器宕机了。如果没做消息持久化,这笔订单就永远丢失了!

核心价值:

1️⃣ 故障恢复:MQ重启后从磁盘恢复未处理消息

2️⃣ 数据可靠性:避免因进程崩溃/网络抖动导致消息丢失

3️⃣ 消费回溯:支持重新消费历史消息(尤其Kafka)

📌 高频考点:面试官最爱问「如何实现100%消息不丢失?」—— 持久化+确认机制+冗余存储 才是完整答案

三、持久化的底层实现套路

▶ 磁盘写入策略对比

| 方式 | 吞吐量 | 数据安全 | 代表MQ | |---------------|--------|----------|------------| | 异步刷盘 | 高 | 可能丢失 | RabbitMQ | | 同步刷盘 | 中 | 零丢失 | Kafka | | 内存映射 | 极高 | 较高 | RocketMQ |

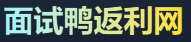

▶ Kafka的持久化黑科技

- 顺序写磁盘:比随机写快600倍(实测数据)

- 分段日志存储:将大文件拆成1GB的segment文件

- 零拷贝传输:

sendfile()绕过CPU直接发网卡

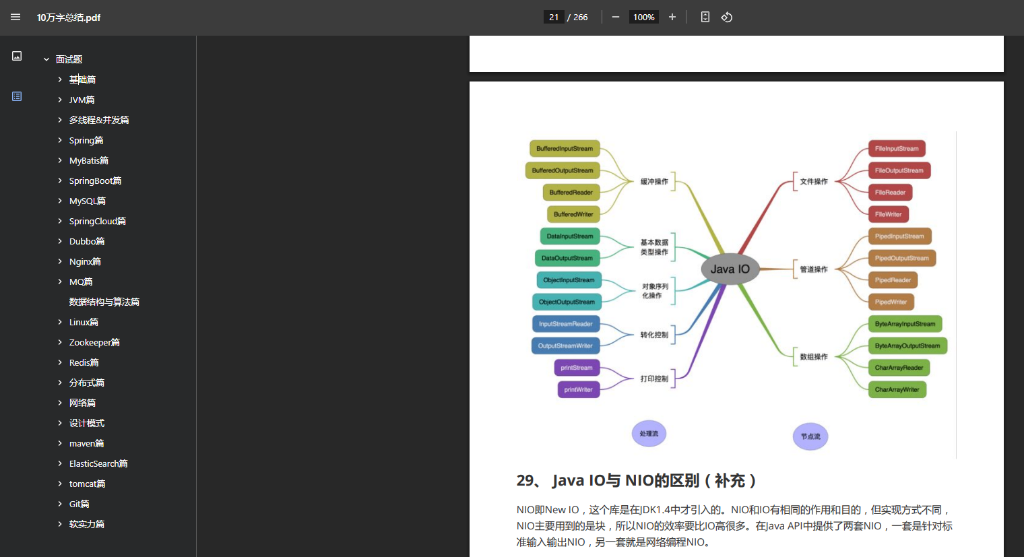

graph LR

生产者-->|1. 发送消息|Broker

Broker-->|2. 写入PageCache|内存

Broker-->|3. 同步刷盘|磁盘[(CommitLog)]

消费者-->|4. 从磁盘读取|Broker

四、面试避坑指南

被问到「你们的MQ如何做持久化?」时,千万别只说_“我们用的Kafka”_就完事了!要展开三个层次:

-

存储层:

“我们采用同步刷盘策略,消息先写入PageCache,再通过fsync强制落盘” -

冗余层:

“所有分区都有2个ISR副本,只有所有副本都持久化成功才返回ACK” -

恢复层:

“Broker重启时会检查未完成持久化的消息,通过HW(高水位)机制截断脏数据”

五、实战场景选择题

💡 当面试官给出场景时,这样拆解:

- 电商下单 → 必须同步刷盘+主从同步

- 日志采集 → 异步刷盘+批量压缩

- 资金结算 → 同步刷盘+事务消息

最后分享个刚整理的**2025版Java面试题库**(含MQ专项),需要的自取~

PS:通过 面试鸭返利网 开通会员可返25元,亲测有效↓

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!