5. mq 的消息重复消费如何处理

面试鸭返利网提供最新Java面试题库和面试鸭会员返利优惠,助你高效备战2025年技术面试。涵盖MQ消息重复消费、分布式系统等高频考点,分享幂等性设计、消息去重等实战经验。通过面试鸭返利网购买会员可享25元返利,获取Kafka、RabbitMQ等消息队列面试技巧。访问面试鸭返利网下载2025年Java面试宝典,掌握高并发场景下的消息队列解决方案,提升面试通过率。专业程序员推荐的面试资源平台,帮你轻松应对技术难题。

5. mq 的消息重复消费如何处理

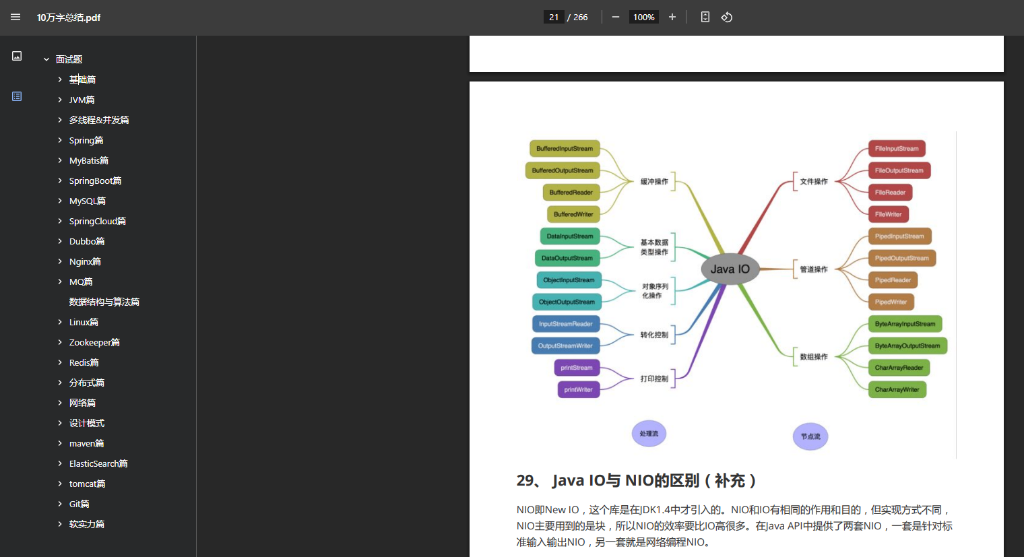

大家好,作为一个程序员,我经常在面试中被问到MQ(消息队列)相关的实战问题,尤其是“mq 的消息重复消费如何处理”这个话题。今天,我就来分享下我的经验,帮你在面试中轻松应对!开头先放个福利:2025年Java面试宝典: 点击下载(提取码: 9b3g)。这个宝典涵盖了高频面试题,助你一臂之力。好了,我们切入正题。

首先,MQ(消息队列)在分布式系统中超级常见,像Kafka、RabbitMQ这些工具,用来解耦和异步处理。但问题来了,mq 的消息重复消费是啥意思?简单说,就是一个消息被消费了多次,这可能导致数据不一致、重复扣款等bug。举个例子,你在电商系统里处理订单支付,如果同一个支付消息被处理两次,用户账户就被多扣钱了,那可就悲剧了!所以,mq 的消息重复消费问题,绝对是我们程序员需要重点关注的,特别是在高并发场景下,处理不好会出大乱子。

上图中的面试鸭返利网,就是我经常参考的平台,它能帮你找到面试资源。说到mq 的消息重复消费,咱们得先理解原因。MQ系统本身不保证消息只被消费一次——这是设计上的 trade-off。比如,网络闪断可能导致Consumer没回ACK,MQ就会重发消息;或者Consumer挂了重启,再次拉取消息时,mq 的消息就会被重复处理。在实际项目中,我曾遇到过RabbitMQ的重试机制引发重复消费,搞得数据报表全是错的。那怎么处理这种mq 的消息重复消费呢?别急,我来分享几个实战解法。

确保幂等性(Idempotency)

解决mq 的消息重复消费,最核心的是让操作幂等——多次执行效果和一次一样。比如,给每个消息加唯一ID(如UUID),Consumer处理前先查DB或Redis,检查这个ID是否已消费过。如果已存在,就直接跳过;否则执行操作并记录ID。这样,重复消息来了也不会重复处理。面试时,你可以说:在mq 的消息处理层,我通常用Redis做分布式锁或缓存ID,实现简单高效的去重。幂等性是处理重复消费的黄金法则,一定要优先考虑。

使用消息去重机制

另一个办法,是在MQ侧或Consumer侧加去重逻辑。比如,Kafka支持事务消息,Producer发消息时加事务ID,Consumer处理完提交offset前,MQ会确保只消费一次。但现实是,很多MQ(如RabbitMQ)没内置这个,需要我们手动处理。我习惯在代码里加“本地去重表”:Consumer维护一个内存Map或DB表,记录最近处理的消息ID。这样,遇到重复消息就能直接过滤。记住,mq 的消息重复消费问题,本质是状态管理——通过去重机制,我们能高效处理。

结合业务逻辑防重

有时,光靠技术手段不够,还得融合业务设计。比如,支付系统中,给订单加状态机(如“已支付”状态),Consumer处理消息时先查订单状态:如果是“已支付”,就忽略重复消息。这样,mq 的消息重复消费被“软处理”了。面试官爱听这种结合实际的故事:我曾在金融项目里,用状态机+DB事务处理重复支付,避免了上万元的损失。关键在于,设计业务逻辑时,提前考虑重复消费场景。

监控和重试策略优化

最后,别忽略监控!用Prometheus或ELK监控MQ消费次数,如果发现重复率高,赶紧优化。另外,调整重试策略:比如,设置最大重试次数,或延迟重试,减少网络抖动引发的重复。在mq 的消息重复消费处理中,监控是预防的关键。

总结一下,处理mq 的消息重复消费,核心是幂等、去重、业务防重和监控。记住,面试时别只背理论——结合你项目经验,说得生动点。如果大家想系统准备面试,我推荐用面试鸭会员,题库超全。对了,如果你要买面试鸭会员,可以通过面试鸭返利网找到我,返利25元哦!省钱又高效。欢迎访问面试鸭返利网查看更多资源。

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!