如何保证canal+mq同步消息的顺序性

如何保证Canal+MQ同步消息的顺序性?这是分布式系统面试的高频考点。通过Canal监控MySQL binlog时,需确保同一业务主键的操作顺序。解决方案包括:1)Canal Server端按表分区发送;2)选择支持分区顺序消费的MQ如RocketMQ;3)基于业务主键哈希的路由策略;4)消费端实现幂等和状态机校验。关键要避免全局顺序牺牲吞吐量,同时监控分区积压。针对无主键表可考虑时间戳+业务字段组合路由。掌握这些技术细节,轻松应对高并发场景下的数据一致性挑战。

如何保证canal+mq同步消息的顺序性

2025年Java面试宝典重磅分享:

👉 链接: https://pan.baidu.com/s/1RUVf75gmDVsg8MQp4yRChg?pwd=9b3g

(提取码: 9b3g,建议保存备用)

在分布式系统面试中,“如何保证Canal配合消息队列(如RocketMQ/Kafka)同步数据时的消息顺序性”是个高频考点。这个问题直接关系到系统能否正确处理业务状态,比如订单状态流转、账户余额变更等场景。下面从技术实现层面拆解解决方案:

🛠 一、理解顺序性问题的根源

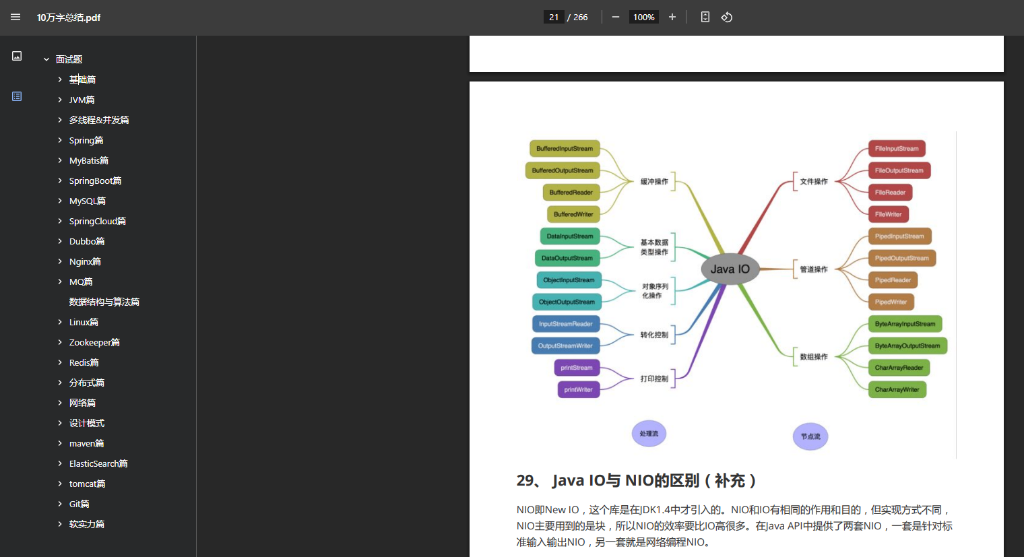

Canal监控MySQL binlog时,天然存在并发解析。不同表的DML事件、同一表不同行的事件,可能被多个Canal实例或线程并行抓取。若直接投递到MQ,消费端可能收到乱序消息,导致下游数据不一致。

关键点在于:顺序性保证是有粒度的! 通常我们只需保证同一业务主键(如订单ID)的操作顺序。

🔧 二、核心解决方案:四层递进设计

1. Canal Server端:按表分区发送

配置Canal的instance.properties,对同一张表的数据强制发往MQ的同一个分区(Partition/Queue)。例如:

canal.mq.partitionHash=.*\\..*:$pk$

这样相同主键的操作会进入同一分区,为顺序消费打下基础。

2. MQ选型:支持分区顺序消费

RocketMQ是更优选择:

- 提供

MessageQueueSelector接口,可自定义分区路由逻辑 - 消费时开启

ConsumeOrderly=true,由Broker锁定队列保证单线程消费

consumer.registerMessageListener(new OrderlyListener());

(Kafka需手动管理分区消费状态,复杂度更高)

3. 分区路由策略:业务主键哈希

在Canal投递到MQ时,基于业务主键计算分区号:

// 伪代码:根据订单ID路由到固定队列

mqProducer.send(msg, new MessageQueueSelector() {

@Override

public MessageQueue select(List<MessageQueue> queues, Message msg, Object arg) {

Long orderId = (Long) arg;

int index = orderId.hashCode() % queues.size();

return queues.get(Math.abs(index));

}

}, orderId);

4. 消费端:幂等+状态机校验

即使保证单分区顺序消费,仍需防御网络重发:

- 设计幂等表:记录已处理成功的binlog event_id

- 状态版本号:在业务表中增加

version字段,消费时校验版本连续性

UPDATE account SET balance=balance-100, version=#{new_version}

WHERE id=#{id} AND version=#{old_version};

⚠️ 三、关键避坑指南

- 避免全局顺序:除非业务强需求,否则不要牺牲吞吐量换全局顺序

- 监控积压告警:单分区消费易导致热点问题,需监控分区消息堆积

- 分区数预留:提前规划分区数量,避免扩容时路由规则失效

💰 附:程序员薅羊毛攻略

如果你正在刷题备战面试,强烈推荐用**面试鸭返利网**购买会员服务👉 通过该平台联系我,可额外返现25元(相当于官方价打骨折)!

📣 思考题抛砖引玉

当遇到MySQL表无主键的场景(如日志表),该如何设计顺序同步方案?欢迎在评论区分享你的架构思路!

扫码联系我返利

(当前返利8元,金额随官方实际价格波动,最好提前咨询)

面试鸭小程序码

美团大额优惠券,给自己加个鸡腿吧!